NVIDIA全栈AI软件在Blackwell GPU上展现卓越推理性能

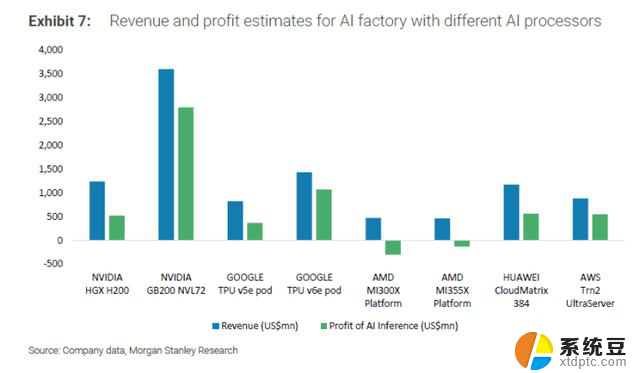

在发布的新数据中摩根士丹利研究部,该公司比较了推理工作负载中人工智能解决方案的运营成本和利润率。据透露,大多数 AI 推理“工厂”或运行多个芯片用于 AI 推理的公司都享有超过 50% 的利润率,而 NVIDIA 在其中处于领先地位。

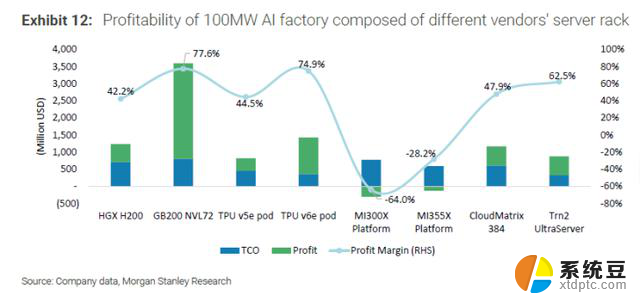

为了进行评估,选择了一系列 100MW 的人工智能工厂,这些工厂由不同供应商的服务器机架组成。其中包括 NVIDIA、谷歌、AMD、AWS 和华为平台。其中,英伟达的GB200 NVL72“Blackwell”GPU平台提供了最高的77.6%的利润率,预计利润约为35亿美元。

谷歌以其 TPU v6e Pod 以 74.9% 的利润率位居第二,第三名是 AWS Trn2 Ultraserver,利润率为 62.5%。其余解决方案确保了大约 40-50% 的利润率,但最有趣的是 AMD 的数据表明他们还有很多工作要做。

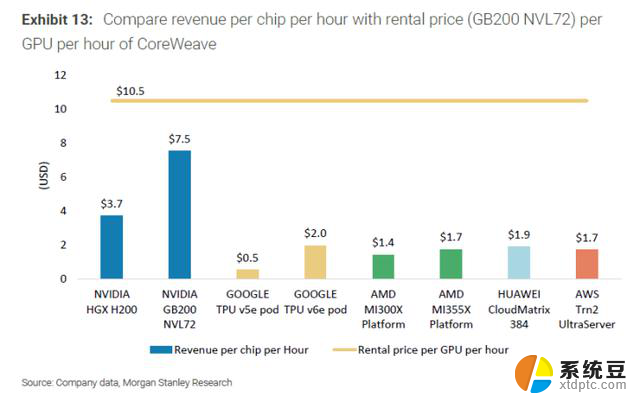

AMD 最新的 MI355X 平台在 AI 推理方面的利润率为负 28.2%,而较旧的 MI300X 平台在 AI 推理方面的利润率为负 64.0%。该公司还将每芯片每小时的收入与租金(平均为 10.5 美元)细分。

NVIDIA 的 GB200 NVL72 芯片每小时收入为 7.5 美元,排名第二的是 NVIDIA 的 HGX H200,每小时收入为 3.7 美元,而 AMD 的 MI1.7X 平台每小时收入为 355 美元。其他芯片大多每小时产生 0.5-2.0 美元的收入,因此 NVIDIA 处于完全不同的水平。

NVIDIA 在 AI 推理方面的巨大领先优势归功于其 FP4 支持和对 CUDA AI 堆栈的持续优化。该公司已经对其几款旧 GPU 展示了“美酒”处理,例如 Hopper 甚至 Blackwell,它们每个季度的性能都会继续提升。

AMD 的 MI300 和 MI350 平台在硬件方面也很棒,该公司在端一直在做大量的软件优化。但看起来 AMD 仍有一些领域需要努力,AI 推理就是其中之一。

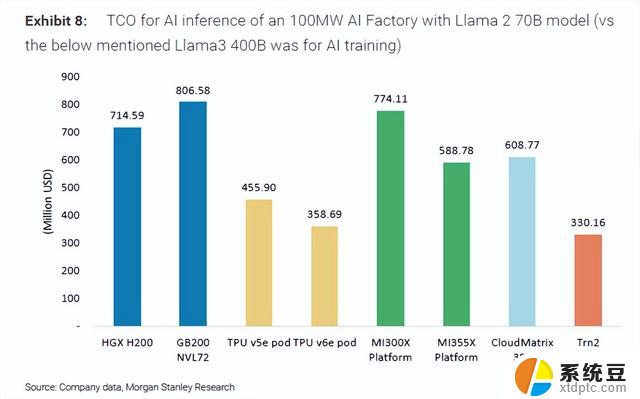

摩根士丹利强调的另一件事是,MI300X 平台的 TCO(总拥有成本)高达 7.44 亿美元,与 NVIDIA 的 GB200 平台相当,约为 8 亿美元。所以成本因素似乎对AMD不利。

较新的 MI355X 服务器的总体拥有成本估计为 5.88 亿美元,与华为的 CloudMatrix 384 相当。较高的初始成本可能是 NVIDIA 如此受欢迎的原因,因为它们在投资成本方面可以与 AMD 相当,但提供更高的 AI 推理性能,据说未来几年将占 AI 市场的 85%。

NVIDIA 和 AMD 还专注于年度节奏,以保持彼此的竞争力。NVIDIA 将于今年推出其 Blackwell Ultra GPU 平台,比 Blackwell GB50 提升 200%,明年将推出 Rubin,将于 2026 年上半年投入生产。紧随其后的是鲁宾·奥特尔和费曼。另一方面,AMD 将在明年推出 MI400 来与 Rubin 竞争,我们也可以期待 MI400 对 AI 推理的多项优化,因此对于 AI 领域来说,这将是有趣的一年。

NVIDIA全栈AI软件在Blackwell GPU上展现卓越推理性能相关教程

- NVIDIA即将向中国推出低算力的消费级RTX 4090 D显卡,体验卓越性能与高效能耗比

- NVIDIA 展现节能和 AI 驱动创新的最新成果,助力科技行业发展

- AMD Ryzen AI 9 HX 370性能实测:AI性能大跃进-全面解读AMD Ryzen AI 9 HX 370的性能表现

- 微软在年度Build大会上全面押注AI代理,展示人工智能技术实力

- 七部门共推AI芯片发展,中国市场或将失去NVIDIA

- AMD显卡能原生跑NVIDIA CUDA应用了!速度还挺快,全面解析AMD显卡支持NVIDIA CUDA应用的性能表现

- 特斯拉座舱芯片或升级,AMD推出V2000A系列:革新车内体验与卓越性能共同融合

- AMD超越AI能效目标并树立行业新标准,助力推动人工智能技术发展

- 微软AI代理全面覆盖销售和财务领域,与Salesforce展开竞争升级

- 微软亮出新AI PC,对战苹果?全面对比性能配置和功能优势

- AMD与Intel三巨头推出突破性门显卡,AMD遭质疑不如二手,Intel或借低价逆袭?

- 微软未来多模式交互、Copilot PC、安全云设备发展趋势揭秘

- 主流高性价比AMDcpu性能对比:哪款AMD处理器性能更强劲?

- 微软解释可导致所有加密数据被盗Windows BitLocker漏洞,如何保护数据安全?

- 微软Win11内测新机制精准劝返Chrome重度用户

- 微软宣布Win11 23H2支持终止,建议尽快升级至最新版本

热门推荐

微软资讯推荐

- 1 微软未来多模式交互、Copilot PC、安全云设备发展趋势揭秘

- 2 NVIDIA全栈AI软件在Blackwell GPU上展现卓越推理性能

- 3 微软Win11内测新机制精准劝返Chrome重度用户

- 4 微软宣布Win11 23H2支持终止,建议尽快升级至最新版本

- 5 微软全面接管!全球最大代码托管平台结束独立运营,开启全新篇章

- 6 2025年暑假——学生用显卡怎么选?最全面的选购指南!

- 7 国产CPU的春天来了?国产CPU一哥实现营收大增45%

- 8 英伟达得罪中国将被美国狠吸血,后果不堪设想

- 9 英伟达、宇树科技、银河通用同框发声,人形机器人话题引发热议

- 10 美国用户起诉微软:Win10停止支持是为了强迫用户购买新设备

win10系统推荐

系统教程推荐

- 1 win10读不出u盘内容 WIN10系统插入U盘读不出来怎么办

- 2 汽车有一个门锁打不开 汽车车门锁住打不开怎么处理

- 3 小音响插电脑上没声音怎么设置 电脑插上音箱没有声音怎么处理

- 4 您的浏览器版本过低哦 如何升级浏览器版本

- 5 foxmail imap设置方法 Foxmail IMAP服务器设置步骤

- 6 win10家庭中文版安装密钥 Win10安装密钥激活方法

- 7 win10屏幕设置 win10多屏幕设置教程

- 8 电脑微信换行按哪个键 微信电脑版怎么在发消息时换行

- 9 thinkpad e15触摸板如何打开 联想笔记本触控板设置开启方法

- 10 win11如何设置视频为桌面壁纸 视频动态壁纸设置教程